文章主要提出了一种方法能够均衡的学习multi task learning问题,这种方法的优点是不需要对分布有任何假设,并且对gradient scale的过程是和训练过程同步的,同时文章发现对loss balance和gradients balance是互补的,因此提出了一种混合的方法能够更好平衡gradients和losses。

这篇文章的推导过程还是比较精妙的,我只看懂了70%。

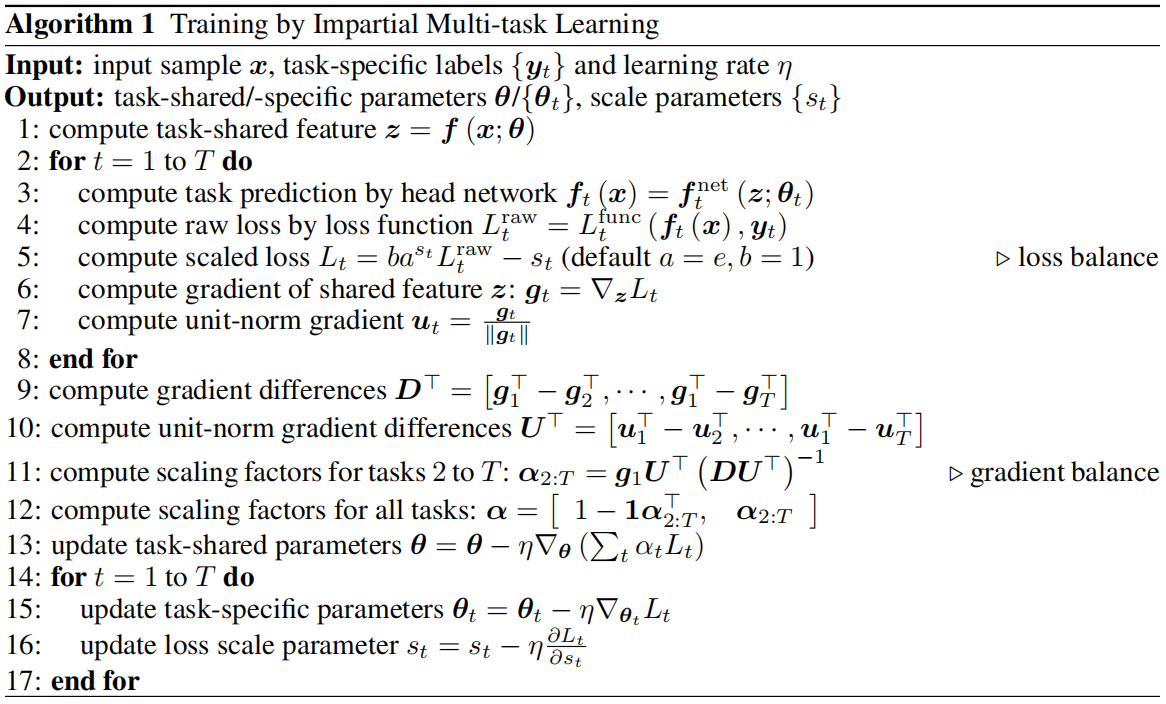

算法

MTL的问题中平衡方法分为loss balance和gradients balance两种,这篇文章综合了这两种方法。

详细解读过程可以看论文阅读的PDF。

gradients balance在文章中提出的方法是IMTL-G,用来更新共享层的参数。

loss balance提出的方法是IMTL-L,通过认为构造scaled loss函数来达到目的。

文章中提出的scaled loss如下所示: \[ g\left( s \right) =e^sL\left( \theta \right) -s \] 这个函数是关于s和\(\theta\)的函数,s是缩放系数,\(\theta\)是各个任务单独的权重,这样就可以在模型中分别求偏导来更新两个变量。

$L( ) \(是原始损失,\)e^s$是为了将s映射到正实数。-s是正则化项,为了避免s找到负无穷的平凡解。

构造scaled loss的原因和过程可以看论文PDF。